Mac本地部署DeepSeek+个人知识库搭建保姆级教程

我猜你最近应该不止一次地听过DeepSeek这个词,这款以逻辑推理能力著称的大语言模型有多先进多厉害我们暂且不提,它最大最大的一个特点是:开源,这意味着你可以很轻松地把它安装到你自己的电脑上,并实现一些神奇的功能。让我花上一点点时间,一步一步地教你如何在自己的Mac电脑上部署本地版的DeepSeek,然后我会更进一步,帮你搭建起一个能使用自然语言沟通的“个人知识库”,让我们开始吧!

事先声明,本期教程主要针对使用M系列芯片的Mac机型,同时macOS版本应不低于12。Intel芯片的机型我个人是不太建议尝试的,如果你不信邪就是想试试看,也没有问题,这期教程也是适用的。另外本期视频的时间轴在这里,你可以根据需要自行跳转到特定的位置。另外视频的文字版和你需要的一切我都会放进分享中心,不用担心找不到。

我们需要用到的软件只有两个Ollama和AnythingLLM

前者用来在本地安装和运行包括DeepSeek在内的各种大模型,后者则提供了一个清晰易懂的用户界面,充当你与大模型沟通的桥梁,实现一般对话和知识库问答功能。

首先我们来搞定Ollama和DeepSeek模型的本地部署。打开Ollama官网https://ollama.com/

下载好的安装包在这里,可以直接使用

点击Download,再点击Download For macOS,你会得到一个名为Ollama-Darwin.zip的文件。插一句题外话哈,有小伙伴知道文件名中的Darwin是什么意思么?可以在弹幕或评论区分享一下。双击打开这个zip文件,你会得到一个远看像羊驼近看更像羊驼的东西,把它拖动到访达边栏的应用程序文件夹即可完成Ollama的安装。接着在应用程序中双击打开Ollama,你看它就是只羊驼嘛……点击Next,再点击install,输入你Mac的开机密码并点击好,当你看到Run your first model安装就完成了。Ollama本身是没有用户界面的,只要看到这只羊驼跑到你的菜单栏上了说明一切正常。

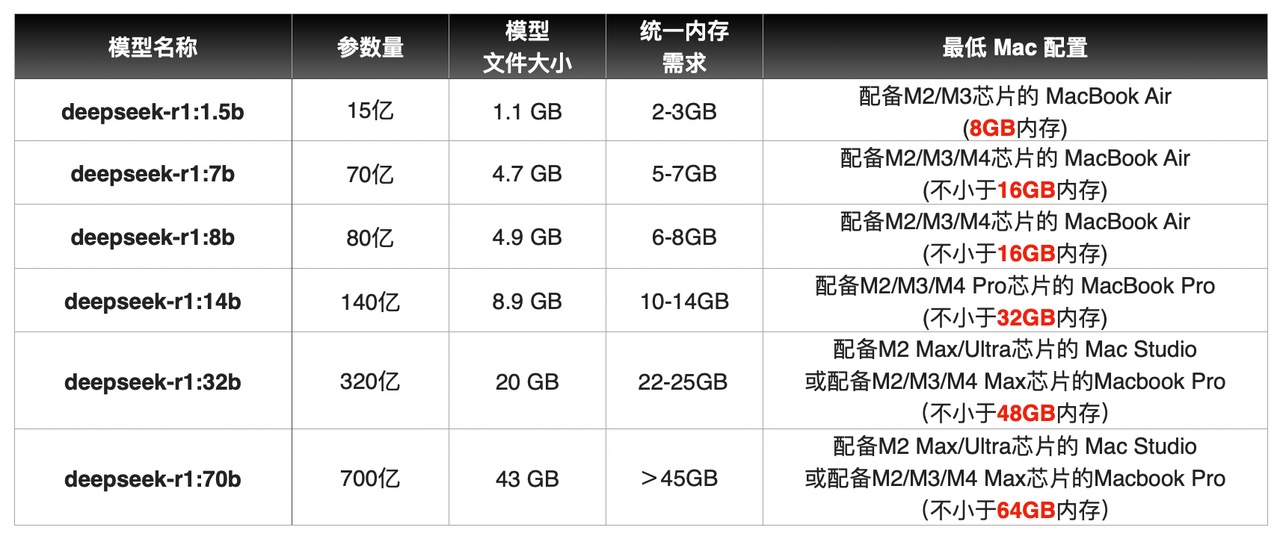

安装好Ollama我们就要部署DeepSeek模型了,别一听部署模型就觉得特别难,其实超级简单。我们要使用的DeepSeek-R1模型一共有7个不同的规模,或者叫不同的版本吧,以模型的参数量进行区分,其中这个b代表billion,也就是10亿

那么最小的1.5b模型就拥有15亿的参数量,而最大的671b则有6710亿个参数,我们要使用的是前面这6个规模较小的模型。

其实这里要展开讲的话有很多东西可以分享,例如只有这个671b的模型才是原版的DeepSeek,其他较小的模型都是通过它“蒸馏”而来的;以及你会在这些小模型的完整名称里看到Qwen的llama的名字,它们是蒸馏时使用的基底模型,当然这些什么“蒸馏”啊、“基底模型”啊我就不展开讲了各位可以自行去探索。通常来讲参数量越大,模型就越“聪明”,同时消耗的资源,这个资源主要指Mac的内存和GPU性能,也就越大。我整理了一个不同规模的模型对应的建议配置供各位参考

你可以根据自己手上Mac的性能选择合适的模型来使用。确定好自己要使用的模型后,聚焦搜索并打开“终端”,当然你也可以在启动台的其他文件夹中打开它,先把输入法切换为英文,接着输入

ollama run deepseek-r1:冒号的后面写上你需要的模型规模,比如你要用7b的模型就写7b,14b就写14b,671b就请受我一拜,输入完成后的指令会像这样

ollama run deepseek-r1:14b按回车确认,模型就会开始下载,这里不需要特殊的网络环境,你懂我意思哈,下载过程可能需要几分钟或者十几分钟时间。

如果发现下载速度变得很慢,可以按Control+C取消,再按方向键上显示最后运行的指令,再按回车让它重连一次也许就会变快,不用担心下载进度是不会丢失的。

当你看到success的提示后模型就部署完成了,是不是非常简单,其实现在你可以直接开始与DeepSeek对话了,比如我们打个招呼,稍作等待就能看到DeepSeek的回应,但是在终端这类命令行工具中与AI对话多少有点不够直观,所以有请我们的下一个工具:AnythingLLM。

AnythingLLM用来替代终端,完成你和AI大模型之间的对话工作,同时它还提供了一样更厉害的能力:检索增强生成,简称RAG,它允许大模型理解你投喂给它的文件,并根据文件中的内容回答你提出的问题,RAG是我们搭建个人知识库的基础。其实类似的工具还有很多哈,例如纯聊天的Chatbox,同样可以用来搭建知识库的Dify、Ragflow、Cherry Studio等等,大多数都是免费的,你可以根据喜好自行选择其他的工具,更多类似软件的网址我放在了文章的最后。但是我个人对比下来更喜欢AnythingLLM,所以此处就以他为例进行讲解了。

同样还是前往软件官网https://anythingllm.com/

点击Download for Desktop,选择macOS,并点击Download for Apple Silicon,如果你是Intel芯片的机型但也想试试看,点击Download for Apple Intel即可。下载完成后双击打开dmg文件,将软件拖动至右侧的应用程序文件夹里安装就完成了。

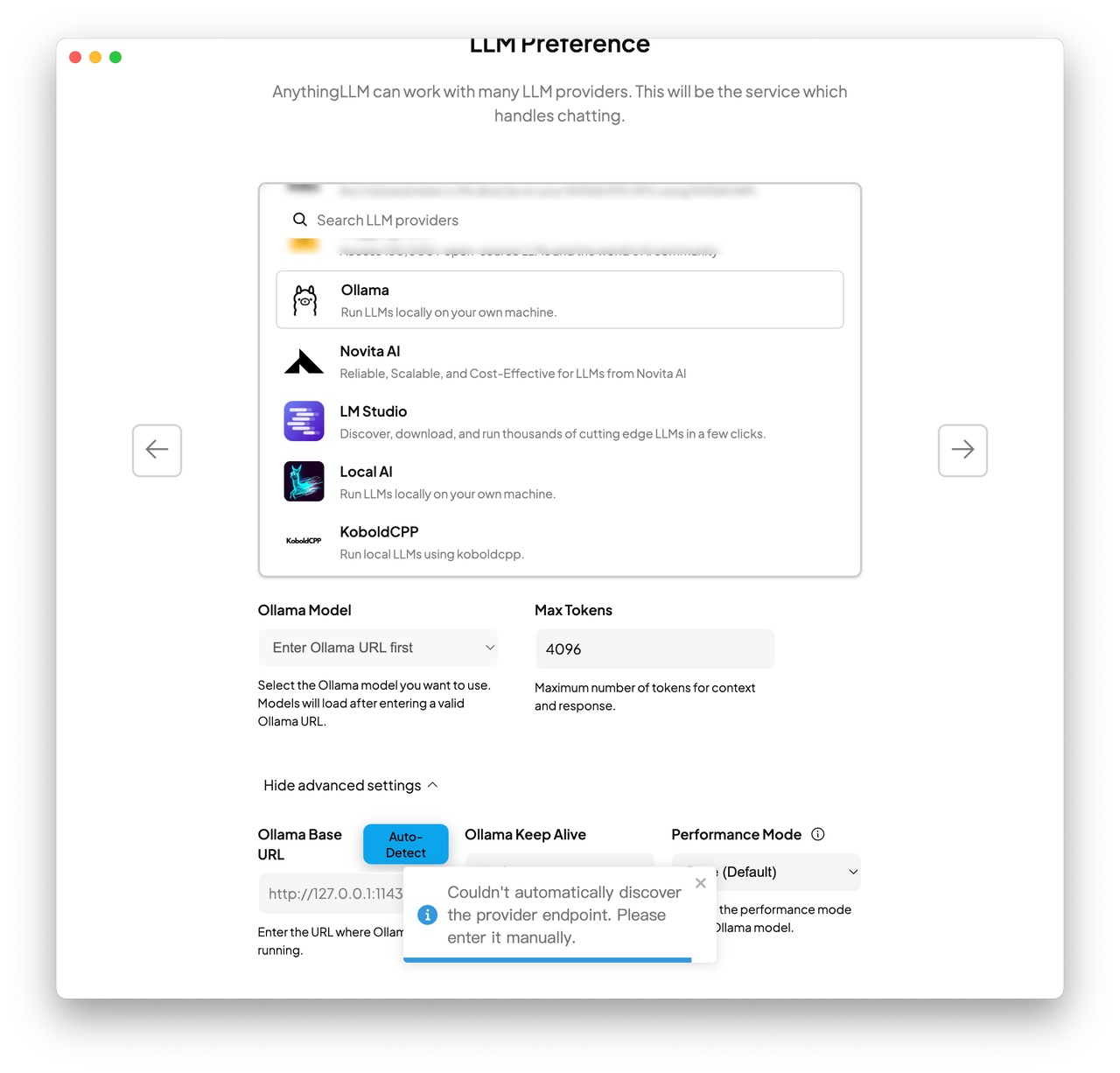

在启动台打开AnythingLLM,初次运行会有一个简单的配置过程,别被这些英文吓倒,我会手把手教你的。

显而易见我们要先点击Get Start

接下来它会要求你选择模型,我们在这个列表中向下滚动,找到并选择Ollama,哎对,就是这只羊驼。此时你一定要确保这只羊驼在菜单栏盯着你,否则会报错的哈。接着在下方的Ollama Model中选择你下载好的DeepSeek模型,其他选项默认即可,点击向右的箭头进入下一步。

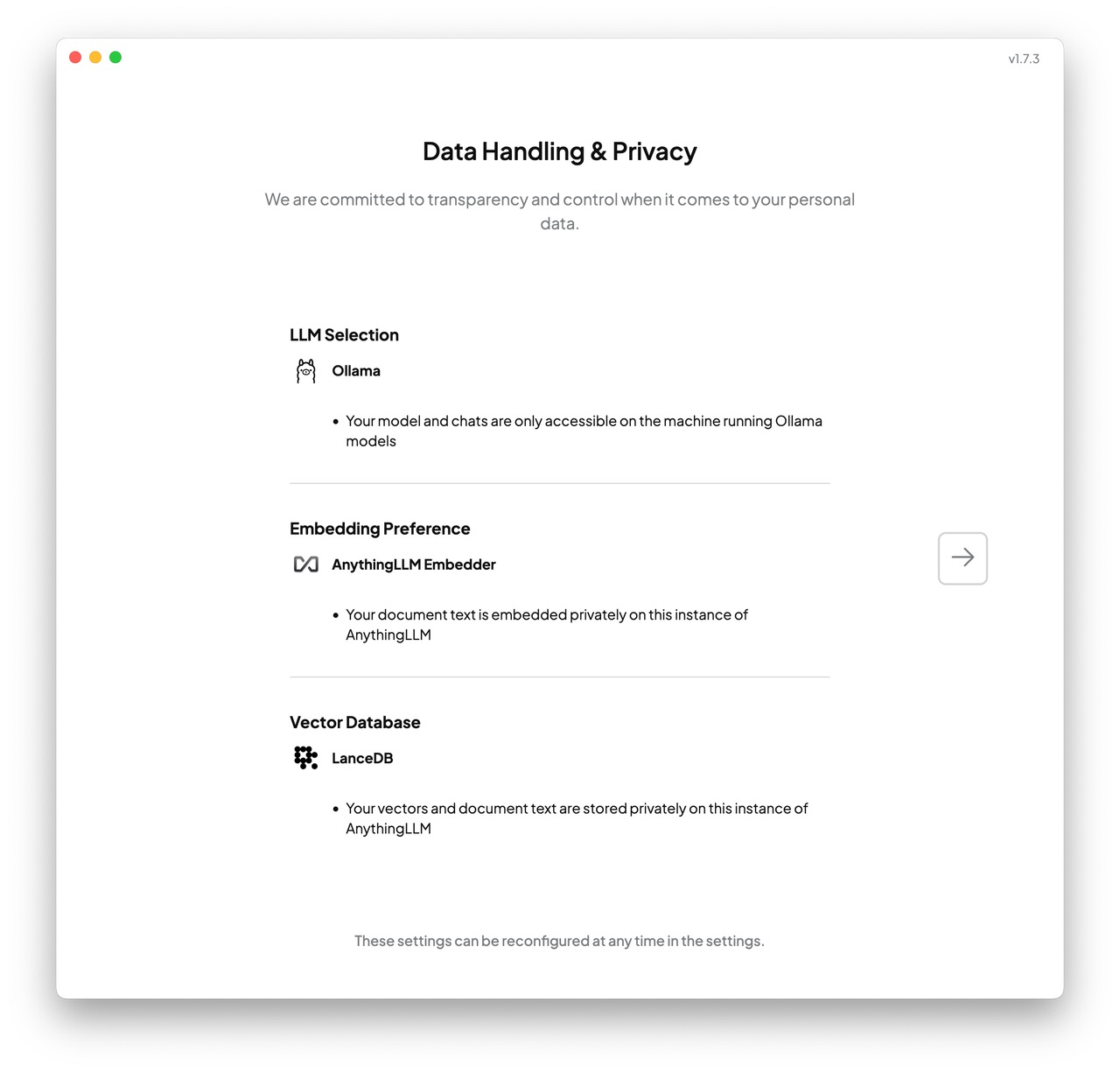

这一页会告知你数据都交给谁了,这几个部分都是运行在本地的,并不会上传给第三方。我们点击下一步

在这一步我们不需要登录,点击下方的Skip Survey即可开始创建工作区。

工作区是什么我们后面再说,现在先给它随便起个名字,比如就叫Test吧,点击箭头继续,设置工作就完成了,接下来我们点击这个小扳手图标进入设置,在Customization页面的Display Language中选择Chinese就能将大部分页面元素切换为中文显示。点击返回按钮,再选择我们刚才建立的工作区,就能开始和DeepSeek进行对话了,我们先来问个好,是不是比用终端聊天优雅多了?AnythingLLM对DeepSeek的支持相当优秀,它能很好地区分AI的思考过程和最终输出的内容,如果你只想问AI一些简单的问题,让它帮你做做数学题或是和它聊聊天,其实到这里就可以正常使用了。

但我们的目标可不止于此,我们需要把自己已有的文档喂给AI,让它借助这些文档来回答你的问题,实现个人知识库的搭建,要做到这一点我们就要让AI能“理解”你文档中的内容,因此我们还需要一类名为Embedding的模型,它负责将你上传的文件拆分成块,转化成AI能理解和调用的形式,这类模型其实也非常多,经过初步尝试我选择了这个名为BGE-M3的模型,它支持100种语言,在各类性能测试中的表现都比较不错。下载BGE-M3非常简单,回到终端,输入

ollama pull bge-m3按回车确认,请注意这里我们把run改成了pull,意味拉取,其实就是下载,看到success的提示说明下载完成。

此时回到AnythingLLM,点击左侧最下方的小扳手进入设置,在人工智能提供商中找到Embedder首选项,在嵌入引擎提供商中选择Ollama,在Ollama Embedding Model中选择你刚下载好的bge-m3,最后不要忘了点击右上角的保存更改。接下来我们点击返回并新建一个工作区,此处我要解释一下工作区了:顾名思义,工作区就是“执行某项特定工作的区域”,这意味着每个工作区应当只专注于一类任务,比如这个工作区用来帮你阅读专业文献,它就不应该同时再帮你解决哲学问题了,请牢记这一原则并为不同的工作创建不同的工作区

此处我希望AI能阅读我汇总的一些Mac疑难杂症极其解决方案,并通过我的提问直接给出答案,那我就将它命名为妙手回春吧!接着我们点击工作区名称后面的上传图标,再将我提前准备好的PDF文件拖动至这个上传区域中,接着选中你上传好的文件,点击Move To WorkSpace,再点击右下角的Save and Embed,此时我们设置的Embedding模型就会开始处理这些文档,当你看到WorkSpace Update Successfully的提示就大功告成了。

关闭上传窗口,回到工作区,我们来问个问题试试看,例如我问它:启动台有空白文件夹删不掉怎么办?看,它根据我上传的文档找到了正确的解决方案,提供了具体指令和详细步骤,非常完美。但此时如果我问他一个文档中没有的问题,它竟然也会像模像样的给你解决方案,如果说的对还则罢了,但AI经常会胡编乱造,一般被称为“幻觉”问题,这些答案就是无意义的噪声了,我们要尽可能规避,因此我们还要对它进行一些额外设置,让它完全基于你提供的文档回答问题。点击工作区后面的齿轮图标,点击右侧的聊天设置,先将聊天模式改为查询,限制大模型仅从你提供的文档中寻找答案。接着我们要调整一下聊天提示,这相当于你给大模型立的一个人设,比如它的身份、语气、是否使用特殊的符号和沟通方式等等,将这里英文的默认内容删掉,写一段中文的进去,例如这样,这里你可以根据喜好随便调整哈。Hold On,我知道你在想什么但我劝你别想了,这些大模型在训练阶段就被植入了伦理准则,你很难得到你想要的结果,不过……谁知道呢?

填写完聊天提示,千万别忘了滚动到页面最底部点击Update WorkSpace,让设置生效。点击小扳手图标进入设置,在窗口左侧找到对话历史记录,点击这个Clear Chats再点击OK,清空一下AI的记忆。返回工作区,再次询问一个文档中没有的问题,此时AI应该会正确做到知之为知之,不知为不知,告诉你他不知道了。不过我还要提醒你,基于大语言模型的人工智能更像人而非电脑,同样的操作有时未必能得到相同的结果,你可能需要根据模型给出的实际反馈对这些设定进行各种微调,这需要一点点的耐心和钻研精神,但当你成功的那一刻,感觉会非常好的。

那么到此为止,我带你了解了如何借助Ollama和AnythingLLM部署一个可以运行在本地的AI大模型,以及如何进一步利用AI大模型的推理和文字生成能力,配合Embedding模型理解你提供的私有数据,搭建一个能通过自然语言交流的知识库。在你和它交流的过程中,所有的分析、推理和生成都发生在你Mac的硬盘和内存中,是否联网都无所谓,你可以放心地将一些不愿意上传到在线大模型网站的文档投喂给它,并通过自然语言让它帮你查找资料,进行分析,我也非常期待各位能把大模型玩出更多花样,如果你有什么有趣的用法,欢迎你在评论区和大家分享。